[2024.07.21]

[RAID 1]

==========================

미션 1

[RAID 5]

> HDD: 3개(20G) + Spare(1)

==========================

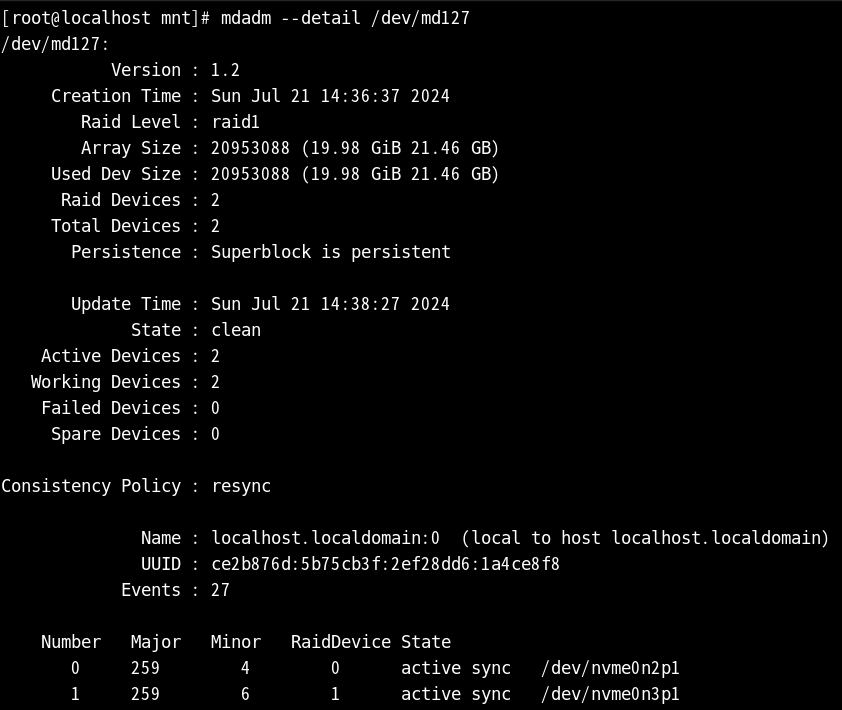

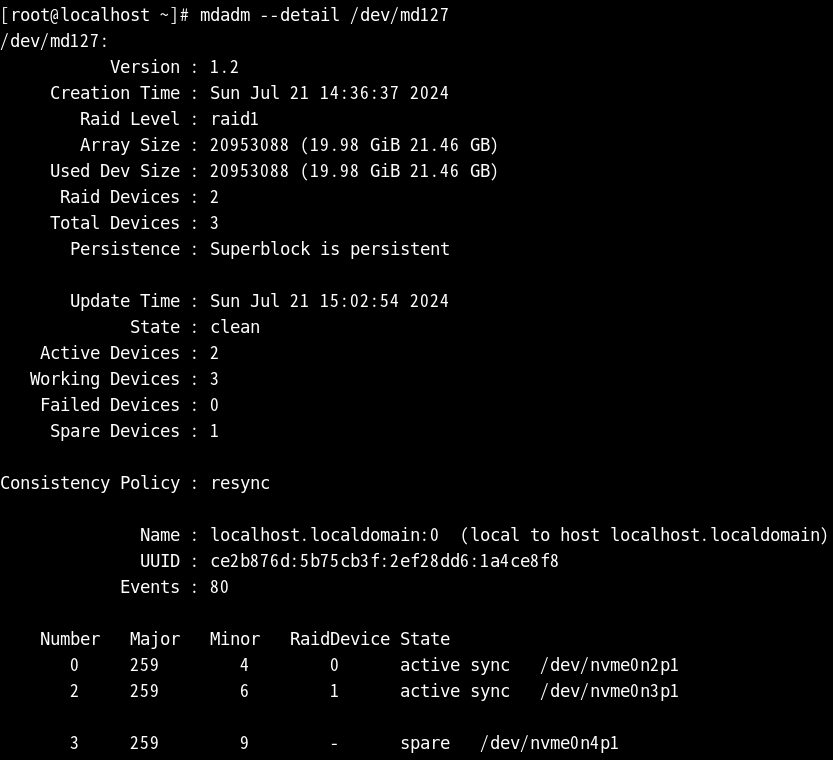

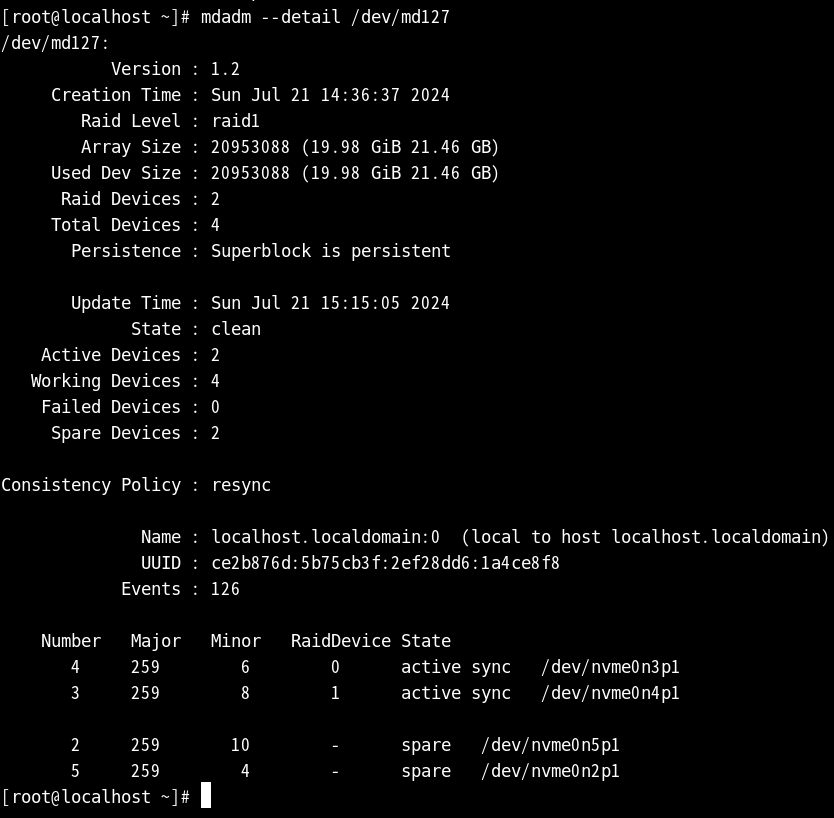

> 상세 정보 출력

#mdadm --detail /dev/md127

> HDD 추가

#mdadm --manage /dev/md127 --add /dev/nvme0n3p1

> HDD 삭제

#mdadm --manage /dev/md127 --remove /dev/nvme0n3p1

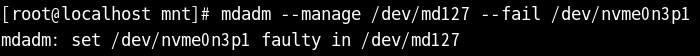

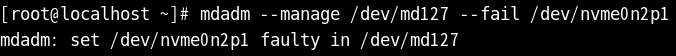

> HDD fail

#mdadm --manage /dev/md127 --fail /dev/nvme0n3p1

> RAID 삭제

#mdadm --zero-superblock /dev/nvme0n3p1 /dev/nvme0n4p1

오늘은 이전 RAID linear에 이어 RAID 1 실습 진행을 하려고 한다

앞서 종료된 상태에서 20G 하드 디스크를 두 개 생성한다

지난 시간에 했던 부분을 그대로 실행하게 되면

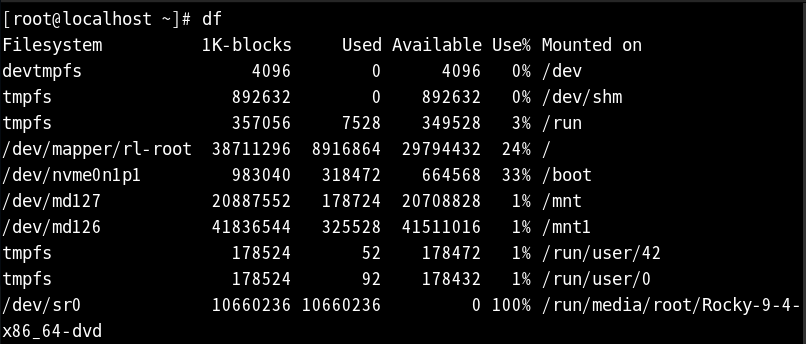

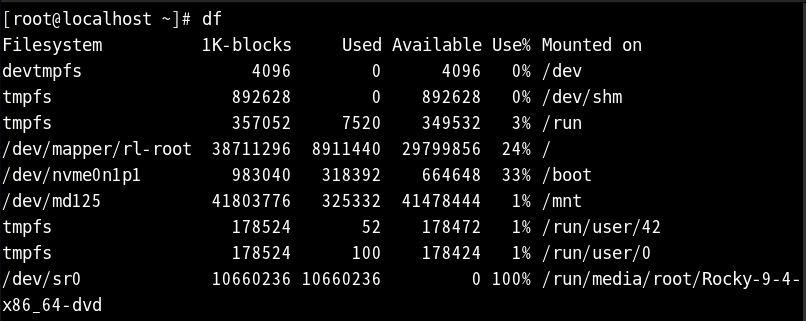

df로 확인했을 때 md127이라는 이름의 파티션이 /mnt 디렉터리에 저장되어 있다

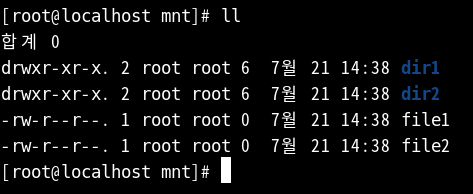

mnt 디렉터리에 dir1, 2 디렉터리와 file1, 2 생성

디테일을 확인하게 되면 두 개의 장치가 생겼다

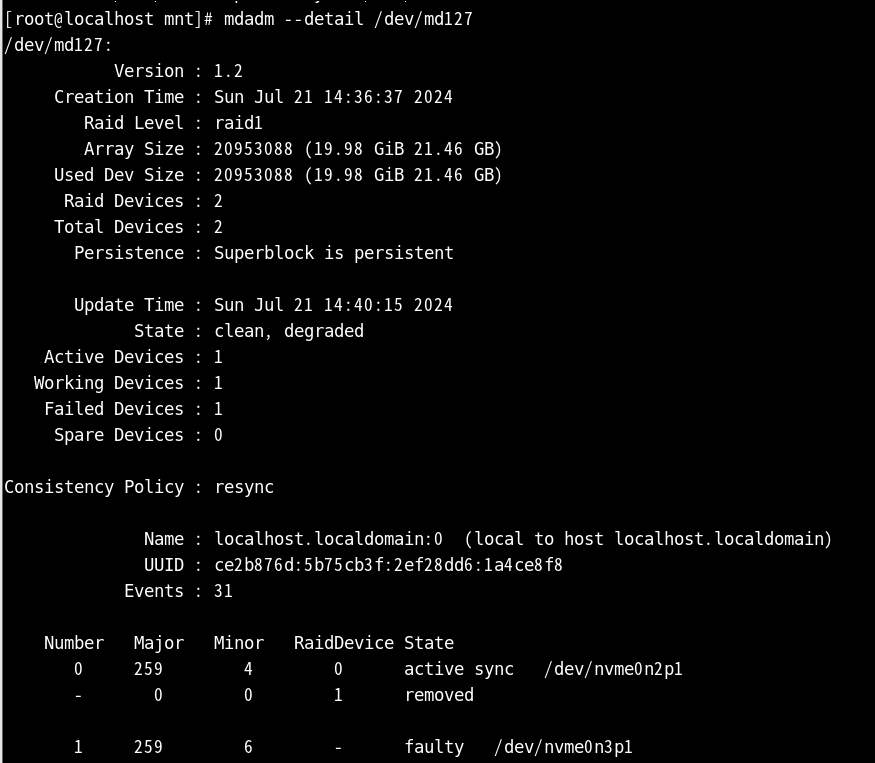

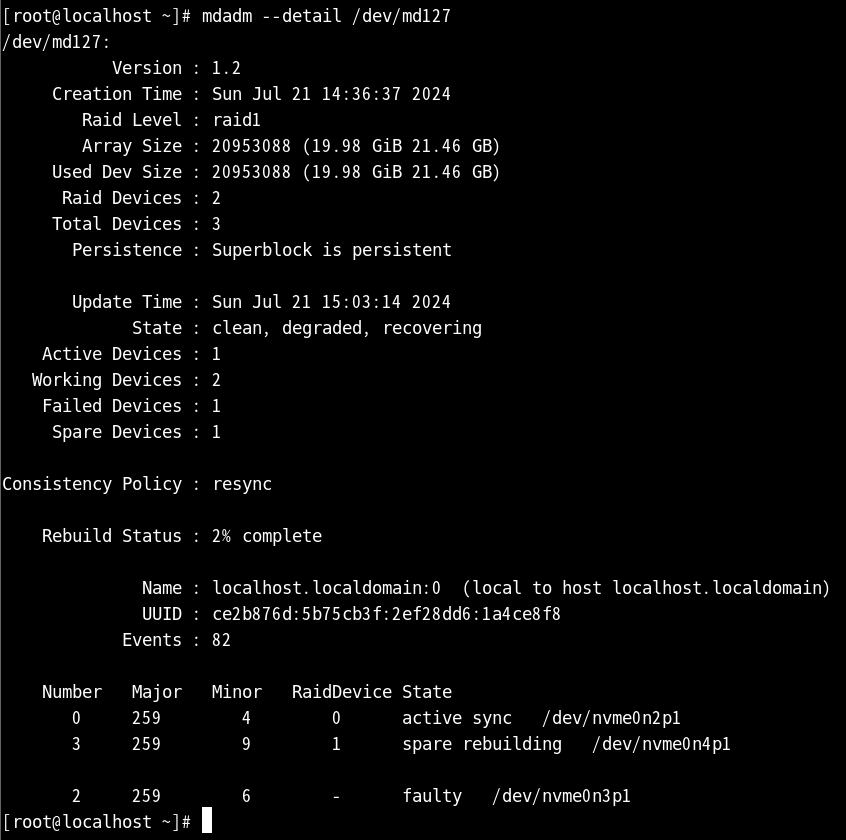

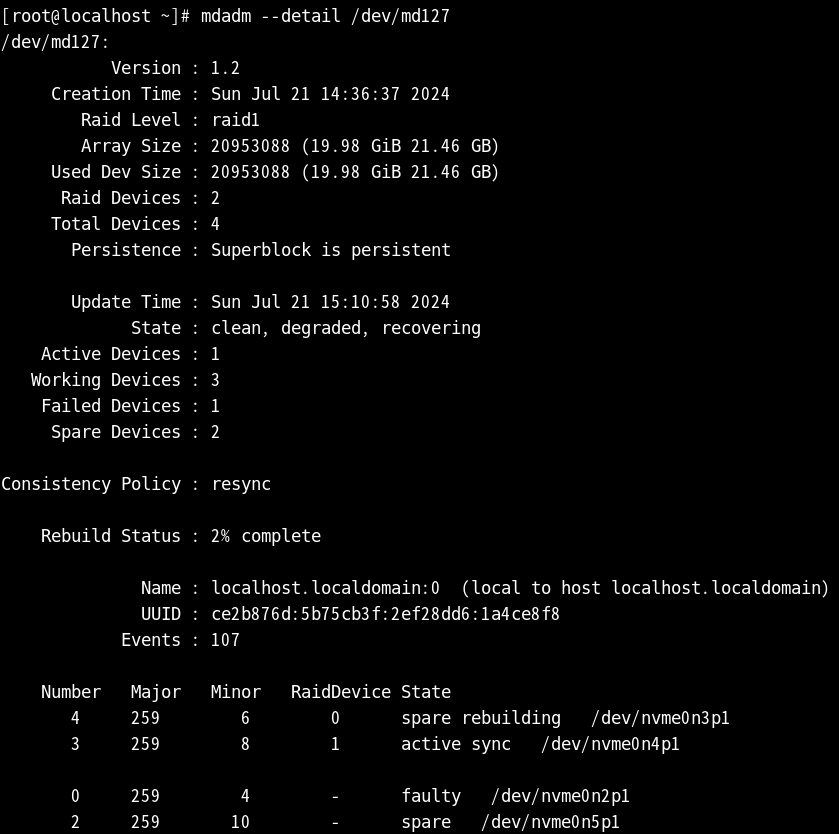

하드 디스크를 fail 시켜 주고 다시 상세 정보를 확인하게 되면

삭제시킨 nvme0n3p1은 faulty 상태가 되고 nvme0n2p1만 남게 된다

하지만 하나가 제거되어도 하나는 사용할 수 있기 때문에

현재의 화면처럼 파일과 디렉터리는 변동이 없는 걸 볼 수 있다

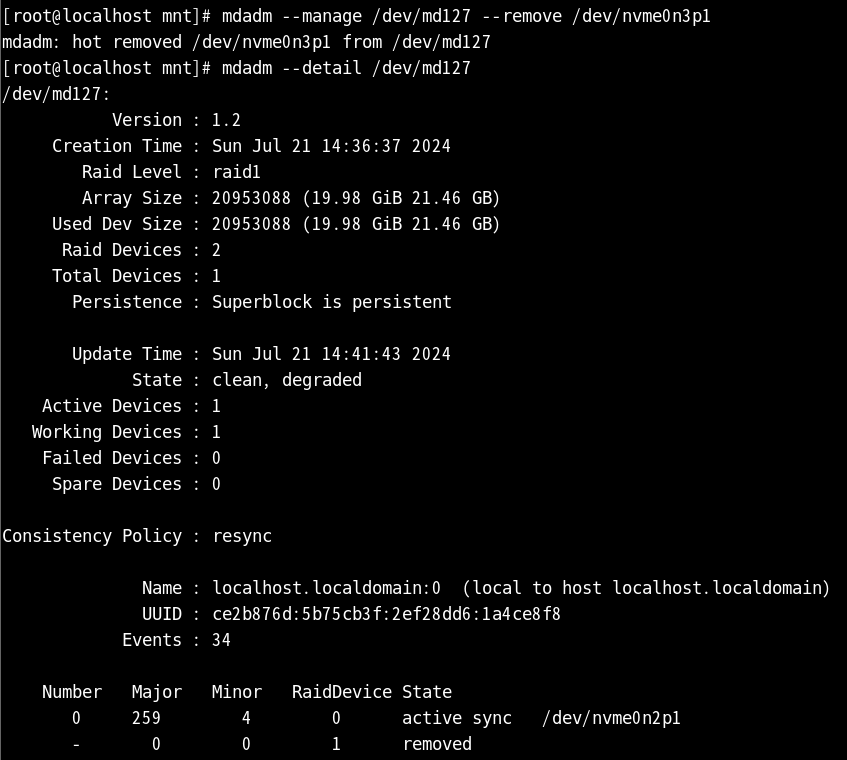

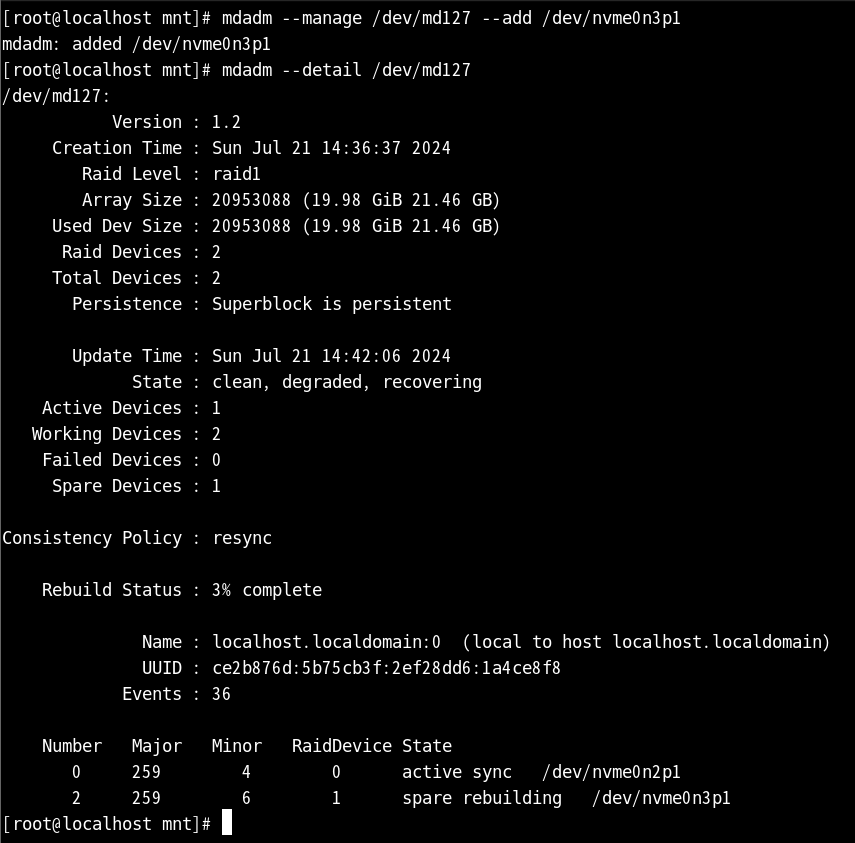

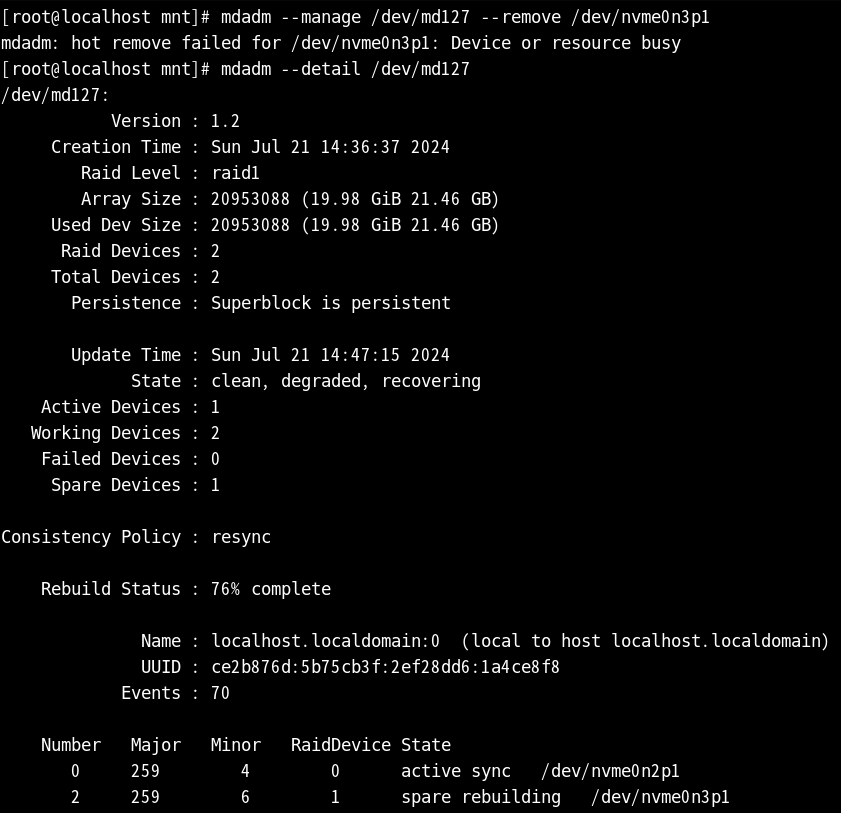

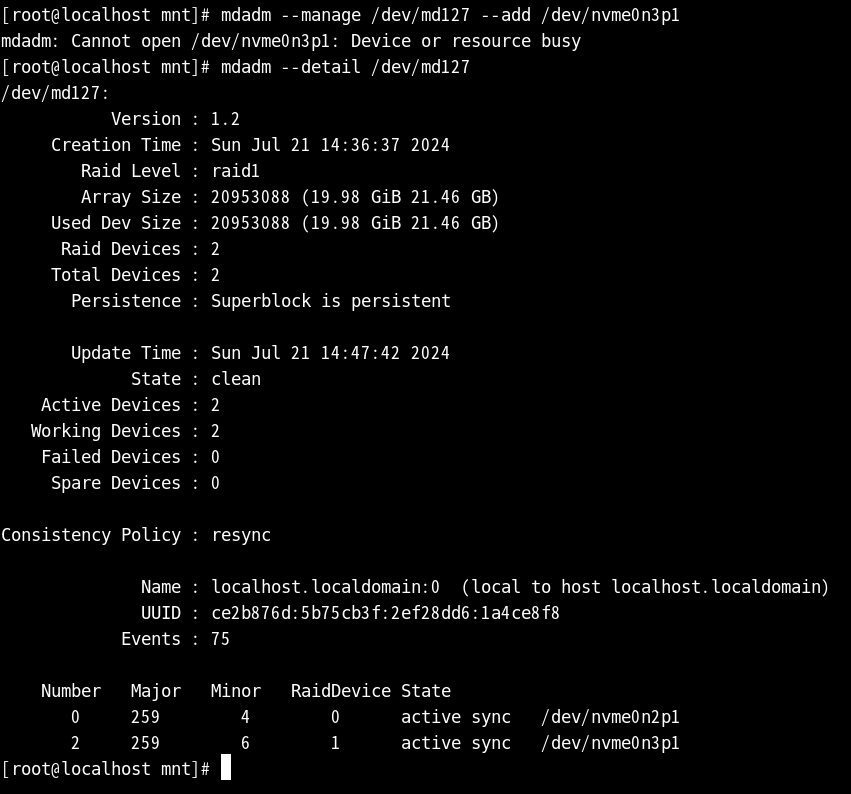

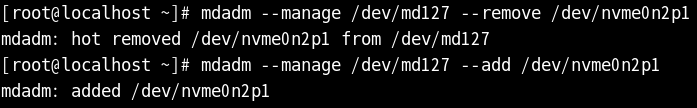

nvme0n3p1을 다시 생성하려면 remove로 먼저 삭제 후

다시 add만 해 주게 되면 다시 추가가 된다

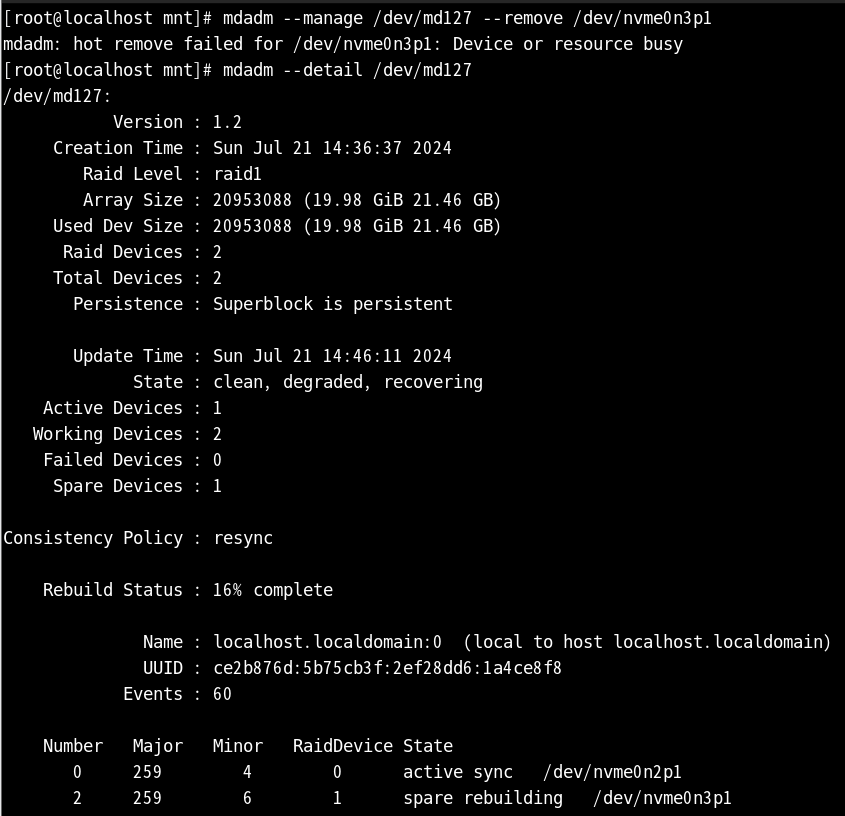

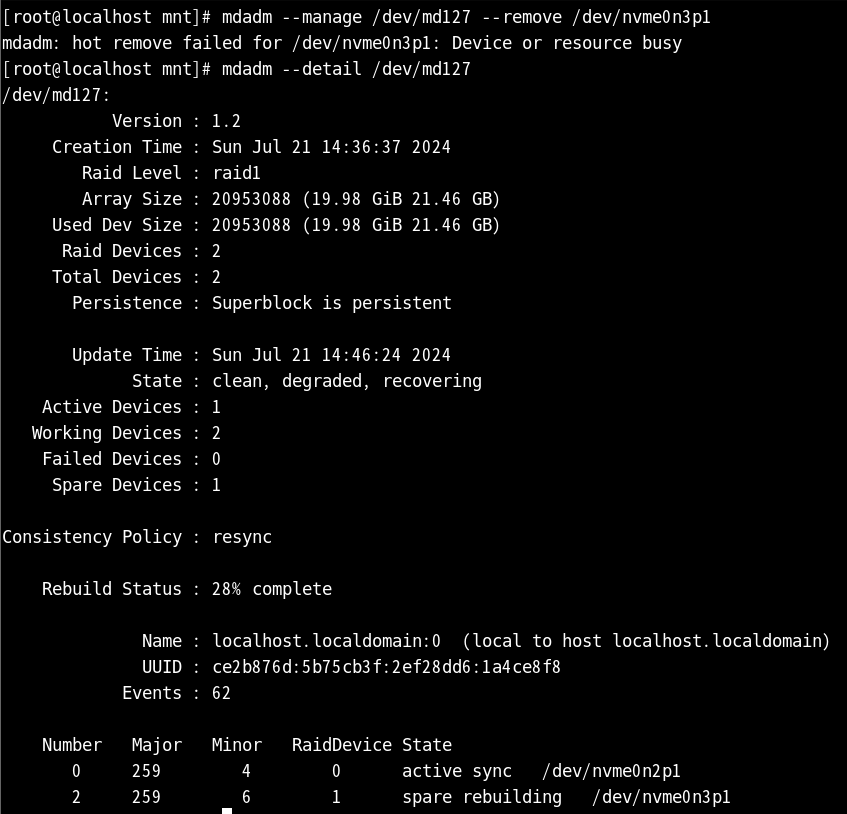

하지만 spare rebuilding 상태가 되어 기다려야 한다

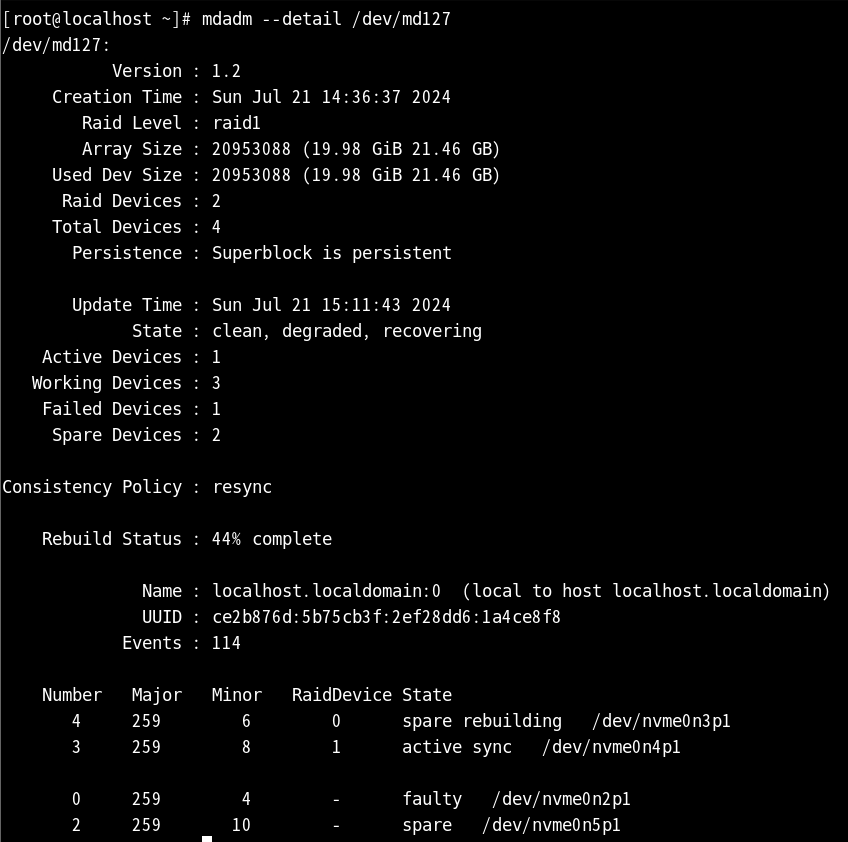

기다리면서 확인하게 되면 퍼센트가 점점 올라가는 것을 볼 수 있다

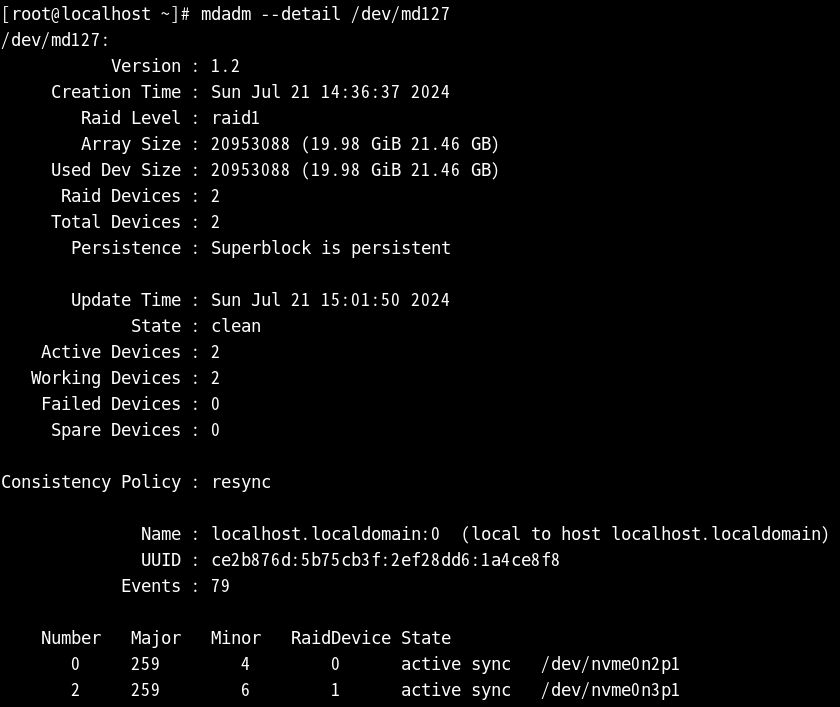

resync 상태일 때 다시 확인하면 원래의 상태로 되돌아온다

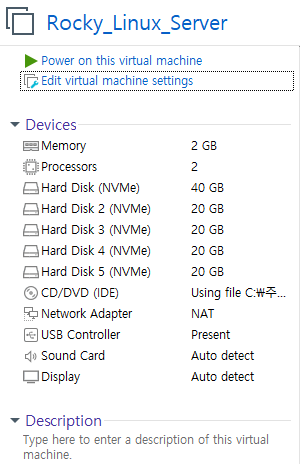

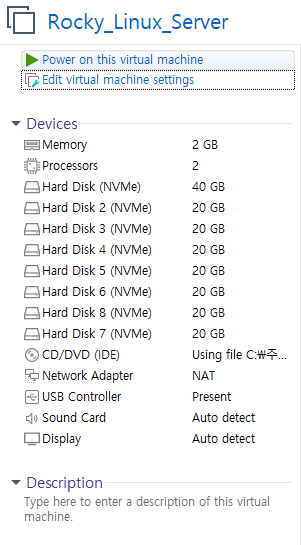

종료 상태에서 하드 디스크 20G 하나를 더 생성한다

원래의 상태는 이렇게 되지만

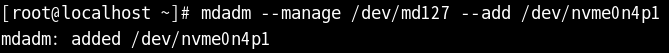

생성한 하드 디스크 파티션을 나눈 후 바로 add로 추가하게 되면

그 하드디스크는 spare 상태가 되어 언제든지 대체 가능한 상태가 된다

nvme0n3p1의 경우 다시 fail을 진행

그렇게 되면 기존의 nvme0n3p1은 faulty 상태가 되며,

원래 자리에는 spare 상태였던 nvme0n4p1이 spare rebuilding 상태가 된다

spare rebuilding의 경우 기다린 후 위의 퍼센트가 채워지고

다 복구가 되면 active sync 상태로 변경된다

마찬가지로 종료된 상태에서 하드 디스크 20G 하나 더 생성시킨다

새로 생성한 하드디스크 파티션 나누고 또 add로 추가시켜 주면 spare 상태가 된다

여러 가지의 경우를 연습해 보기 위해 또 nvme0n2p1을 fail 시켜 준다

그렇게 되면 fail을 진행한 n2p1은 faulty 상태가 되고,

원래의 n2p1 자리에 n3p1이 들어가서 spare rebuilding 상태가 된다

n3p1의 경우 계속 복구가 진행되고 있는 것을 볼 수 있다

faulty 상태인 n2p1을 삭제하고 다시 추가시키게 되면

다시 spare 상태가 되며, 언제든지 대체될 수 있는 상태가 된다

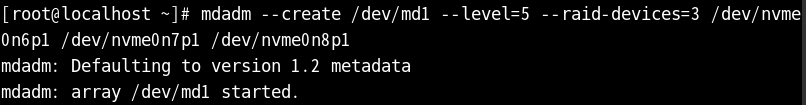

<미션1>

기존에 있던 것을 그대로 두고 20G의 하드 디스크를 3개 더 생성한다

RAID 5를 진행하기 위해서는 레벨 5로 진행해야 된다

파티션을 나눈 하드 디스크 장치 세 개를 입력 후 실행

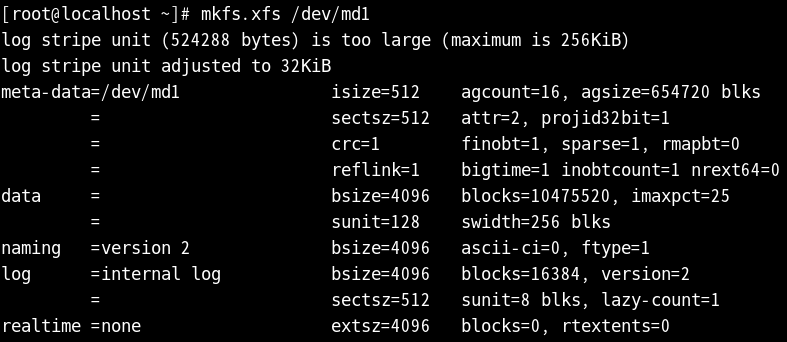

md1으로 설정했기 때문에 md1의 파일 시스템도 생성

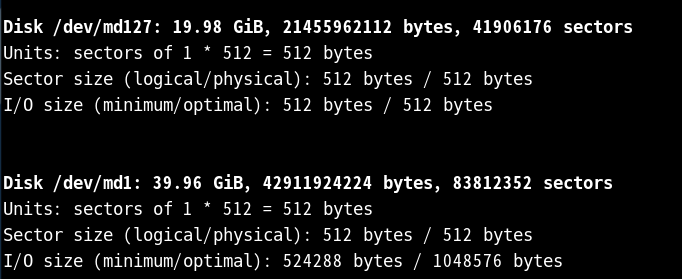

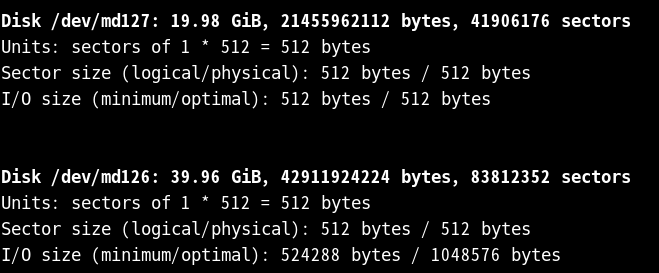

fdisk로 확인 시 현재까지는 md1이다

진행을 위해 한 번 reboot를 진행시킨다

다시 확인하게 되면 md1에서 md126으로 변경되어 있다

현재 디스크를 생성 및 여러 가지를 해 보고 있지만,

디스크 안에서도 데이터가 유실되지 않는 걸 확인하기 위해

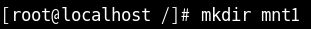

root 디렉터리에 mnt1이라는 디렉터리를 하나 생성하고

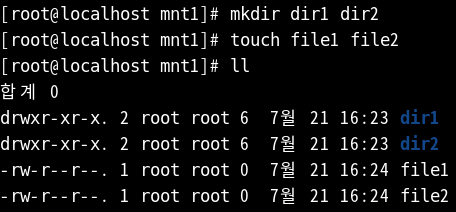

mnt1에 디렉터리 dir1, 2와 file1, 2를 생성시켜 준다

그 후 마운트를 진행한 다음

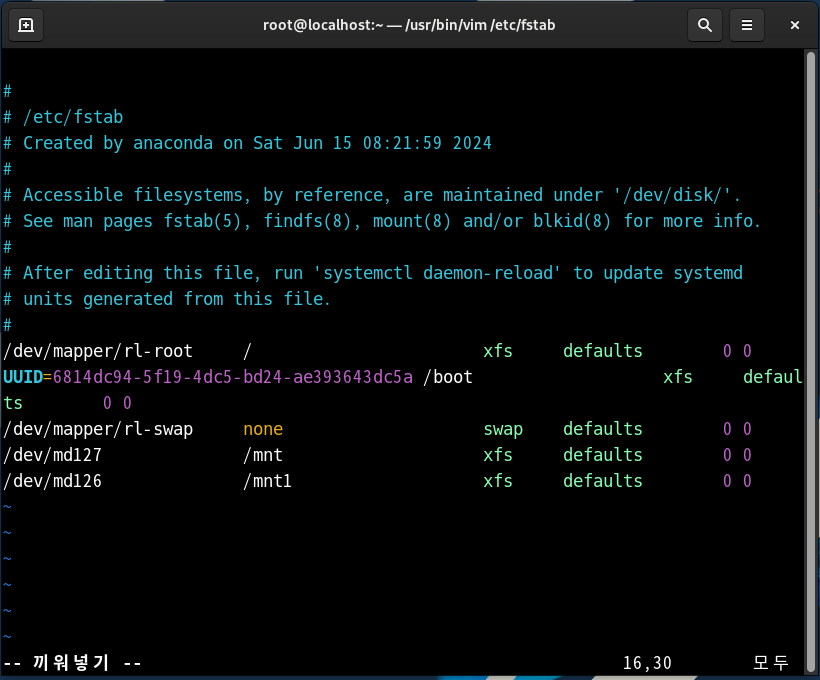

vi /etc/fstab을 이용하여 fstab 파일에서 저장 경로와 장치명 수정

df로 확인 시 md126이 40G의 하드 디스크로 mnt1에 저장된 걸 볼 수 있다

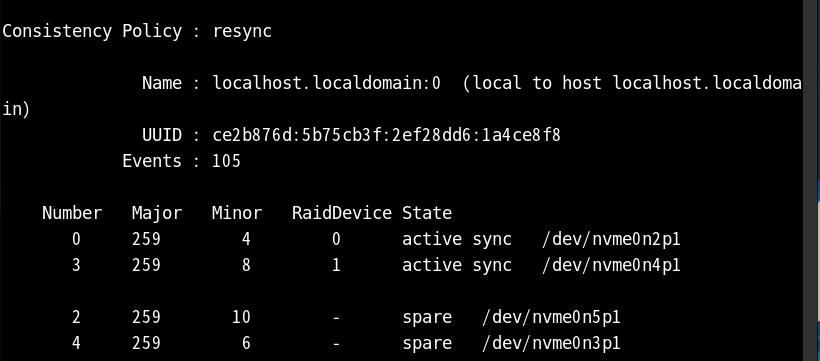

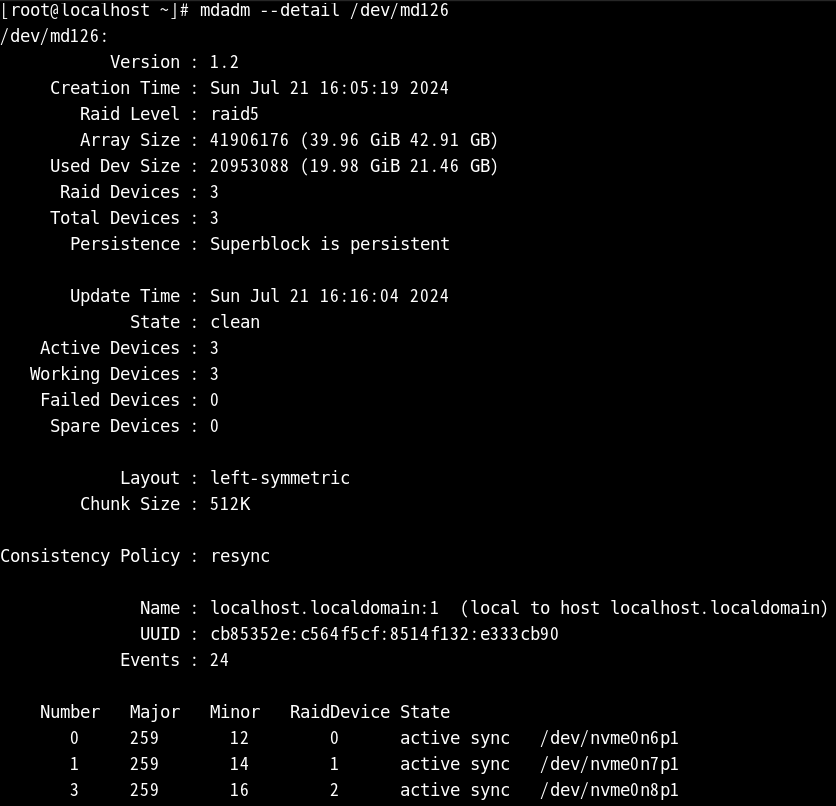

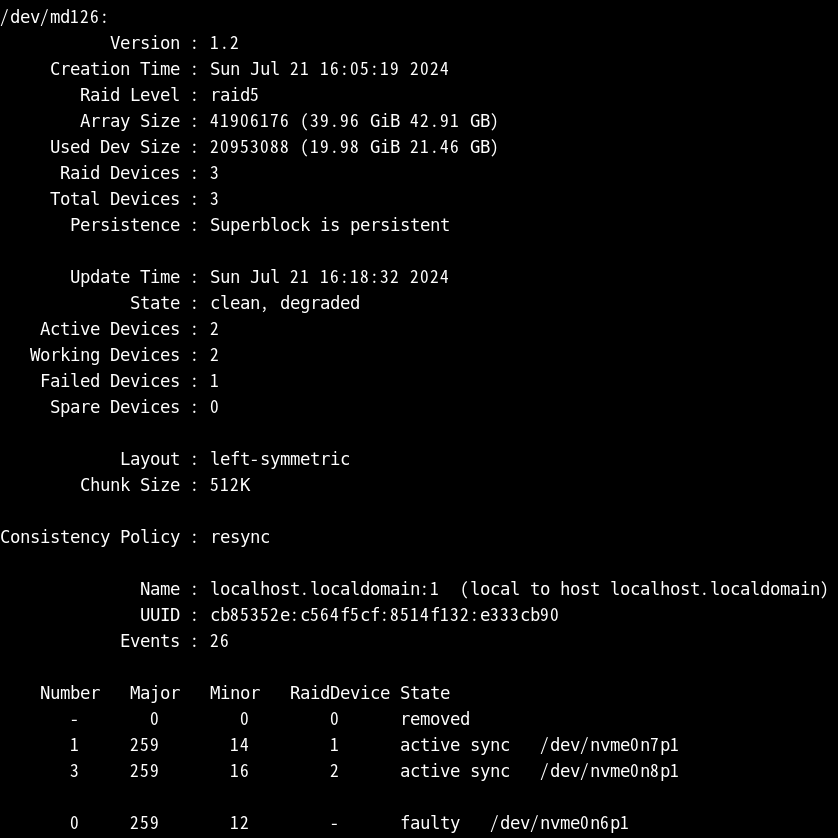

상세 정보를 확인하게 되면 장치 모두 확인된다

미션은 하드 디스크 3개 spare 1개의 상태를 만드는 것이기 때문에

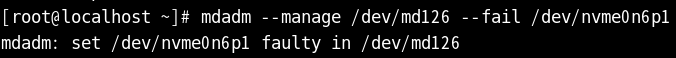

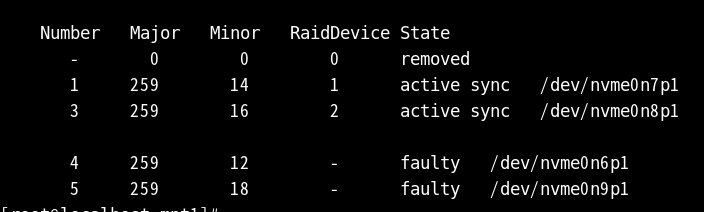

확인을 하기 위해 먼저 nvme0n6p1을 fail 시켜 준다

다시 확인하게 되면 n6p1은 faulty 상태

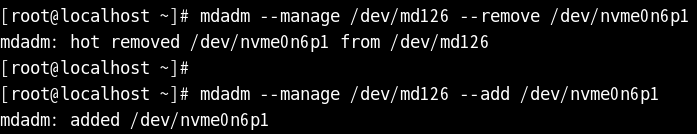

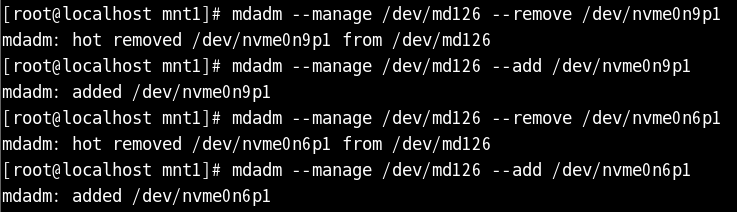

그런 faulty 상태의 n6p1을 삭제 후 다시 추가시킨다

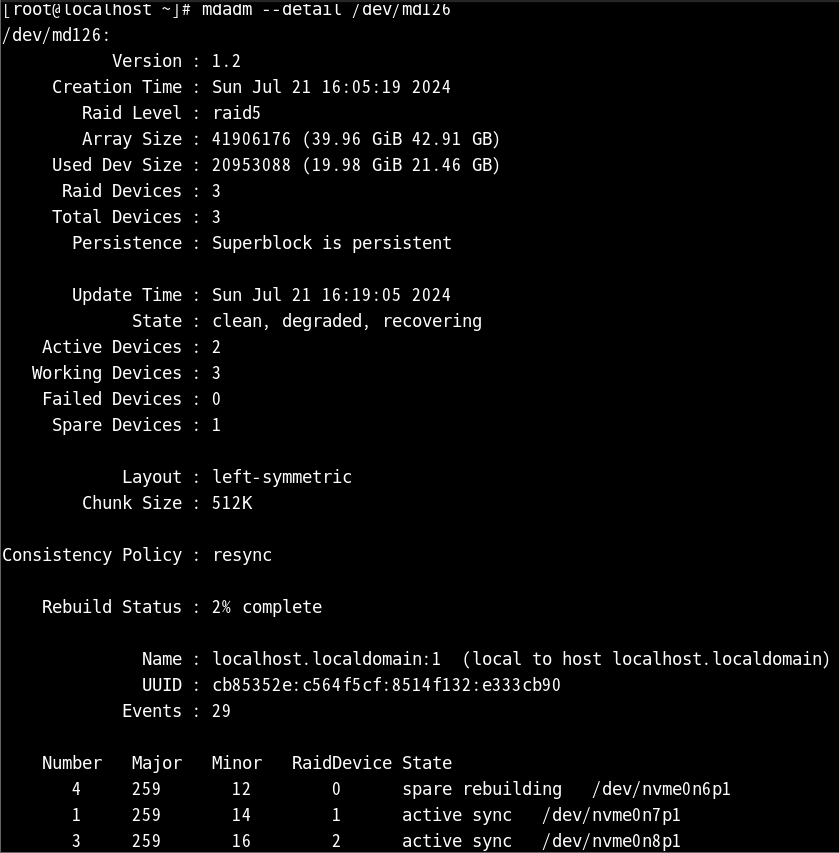

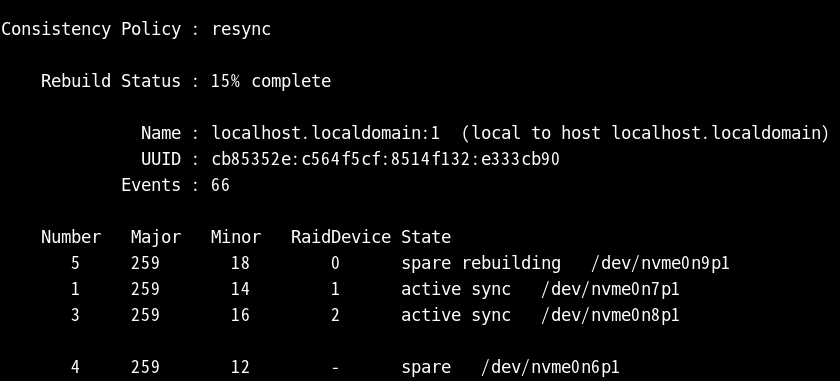

다시 확인하게 되면 n6p1이 spare rebuilding 상태가 된다

하드 디스크 하나를 더 생성하고 파티션을 나눈 하드 디스크를 바로 add로 추가시킨다

이렇게 되면 방금 추가시킨 n9p1의 경우 spare 상태가 된다

n6p1과 n9p1을 fail 진행

다시 삭제 및 추가 진행을 시켜 주고

다시 확인하게 되면 n9p1은 spare rebuilding,

n6p1은 spare 상태가 된 걸 확인할 수 있다

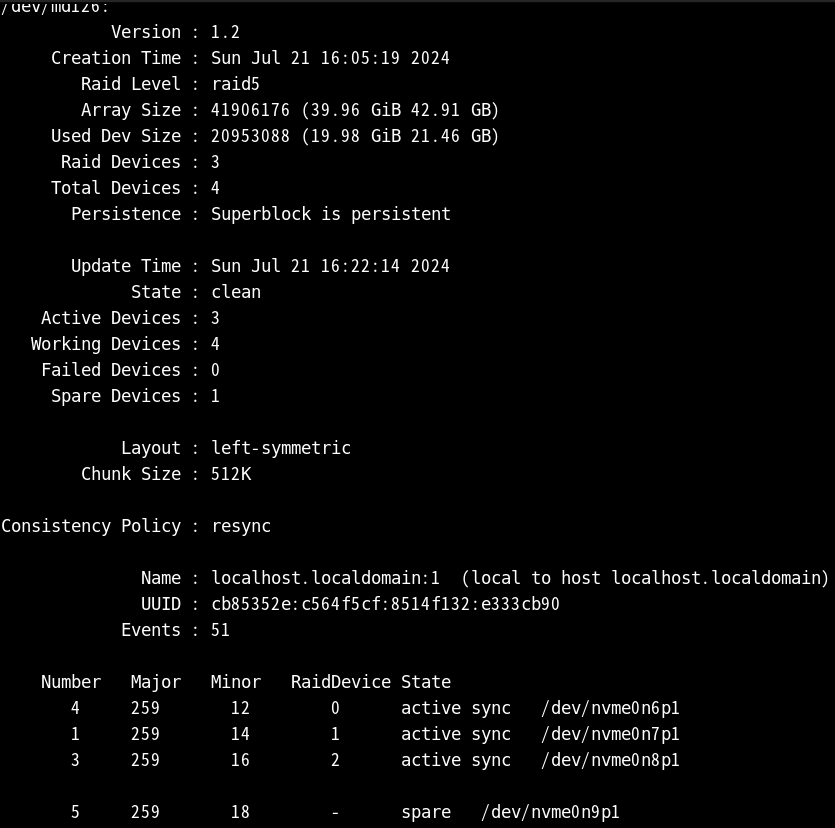

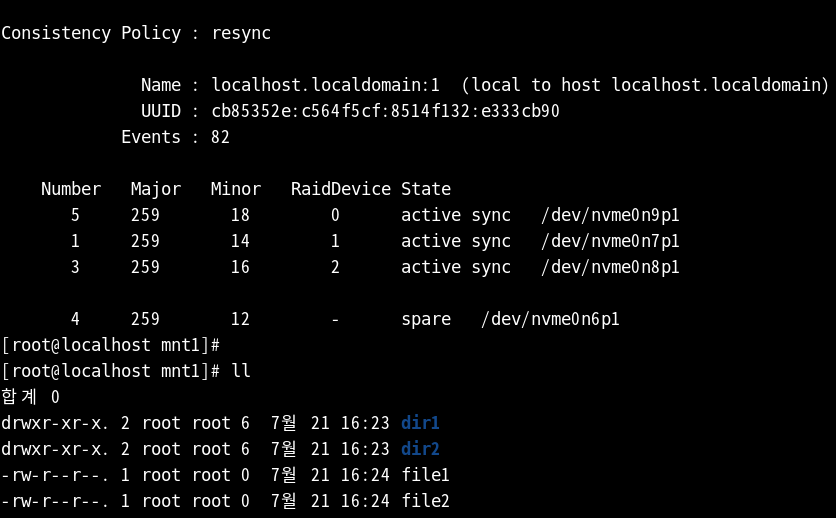

rebuilding 상태를 기다리고 다시 sync 상태가 됐을 때

ll로 파일 및 디렉터리를 확인하면 된다

이때 데이터가 유실되지 않는 걸 확인하는 것이기 때문에

삭제, 추가, fail을 하고 장치들이 옮겨진다고 해서

파일과 디렉터리가 삭제되지 않는 화면을 확인할 수 있다

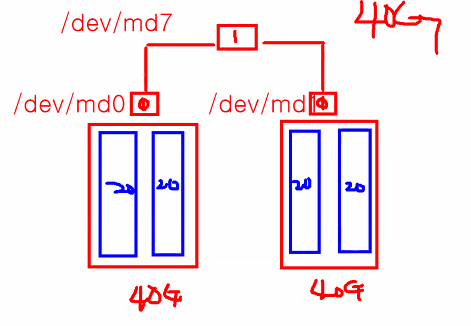

RAID 0+1

md0와 md1을 묶고 다시 md7까지 묶어서 40G를 만드는 것을

RAID level 0+1이라고 한다

0+0로 하고 1로 묶어도 되고, 1+1로 묶고 0로 다시 묶는 방법도 가능하다

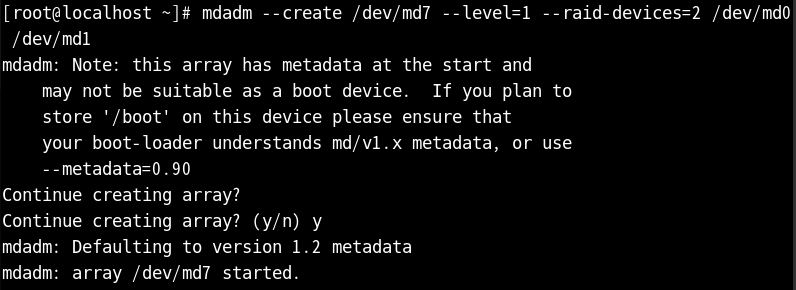

이번에는 RAID 0+1 실습을 진행한다

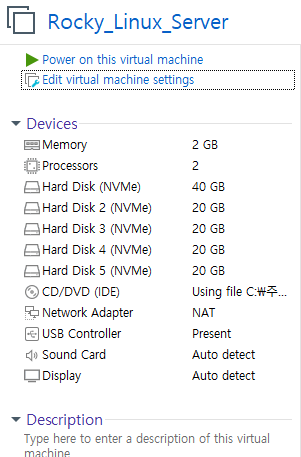

스냅샷을 되돌리고 다시 20G의 하드 디스크 4개를 생성한다

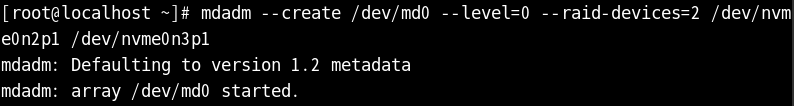

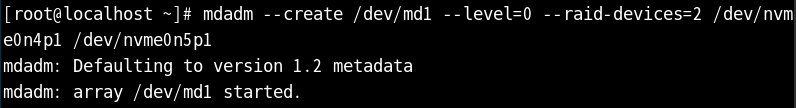

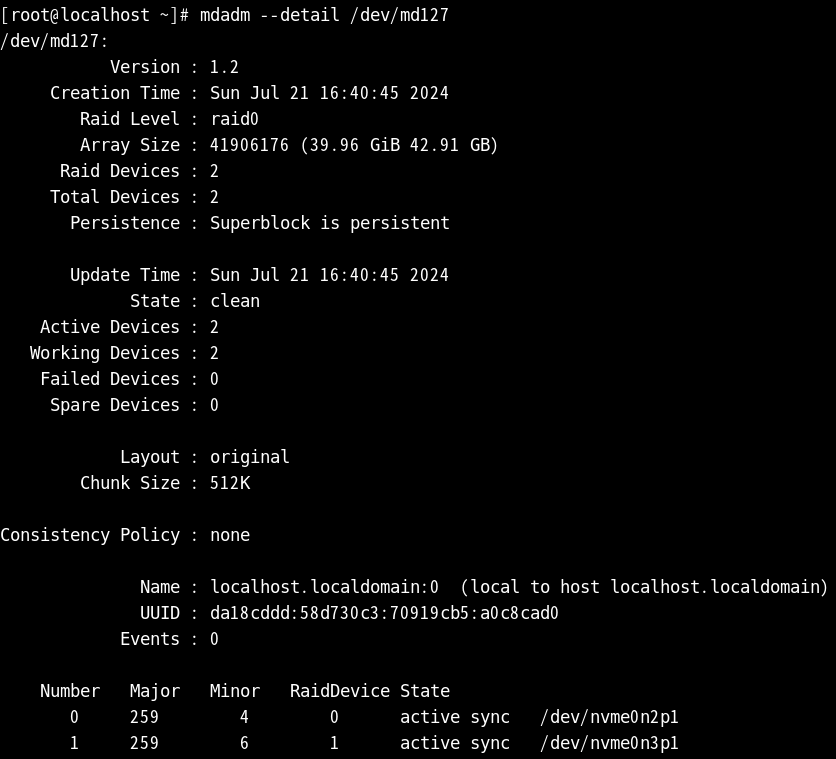

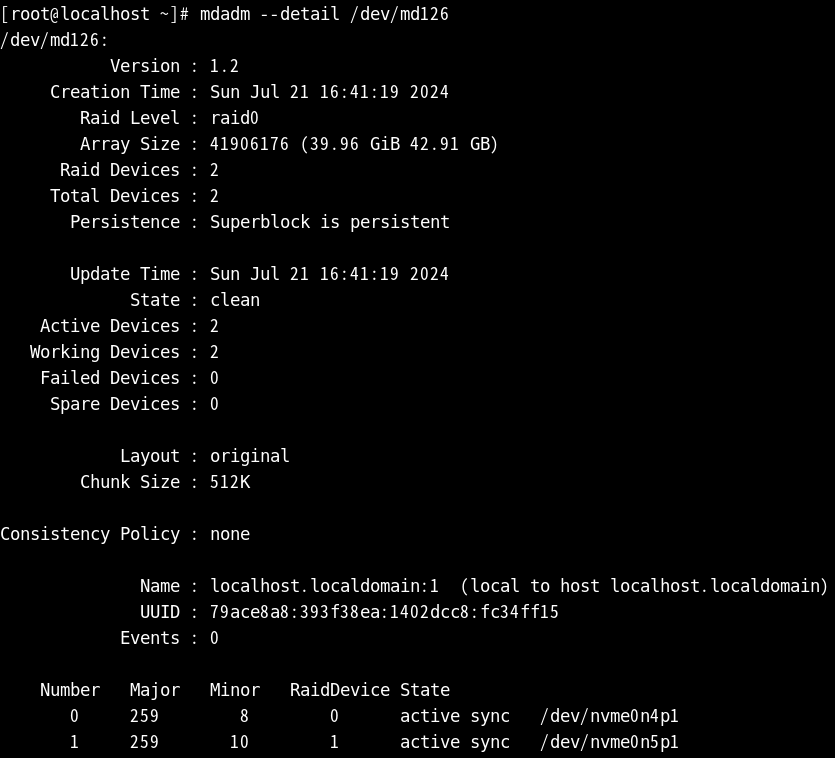

파티션을 나누고 나서 레벨 0의 md0과 md1로

n2p1+n3p1, n4p1+n5p1을 각각 묶어 준다

다시 md0와 md1을 md7으로 레벨 1로 설정하여 묶게 된다

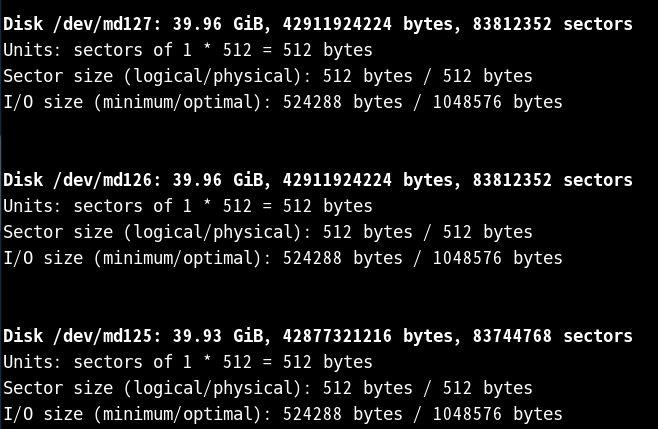

이때 fdisk로 장치명을 확인하면 순서대로 127, 126, 125로 나타나는 걸 확인할 수 있다

*장치명이 변경되지 않고 확인이 불가능하다면 reboot 실행 후 확인을 추천한다

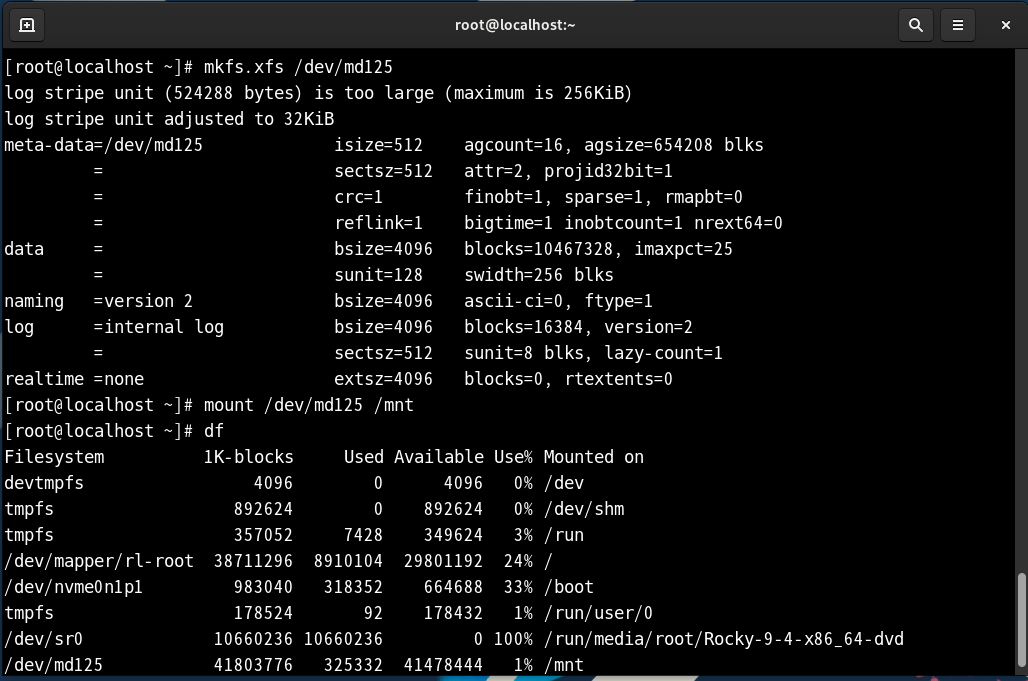

md7은 md125기 때문에 md125의 파일 시스템 생성

파일 시스템 후에는 항상 마운트까지 실행한다

df로 md125가 mnt 디렉터리에 저장된 것을 확인까지 마무리한다

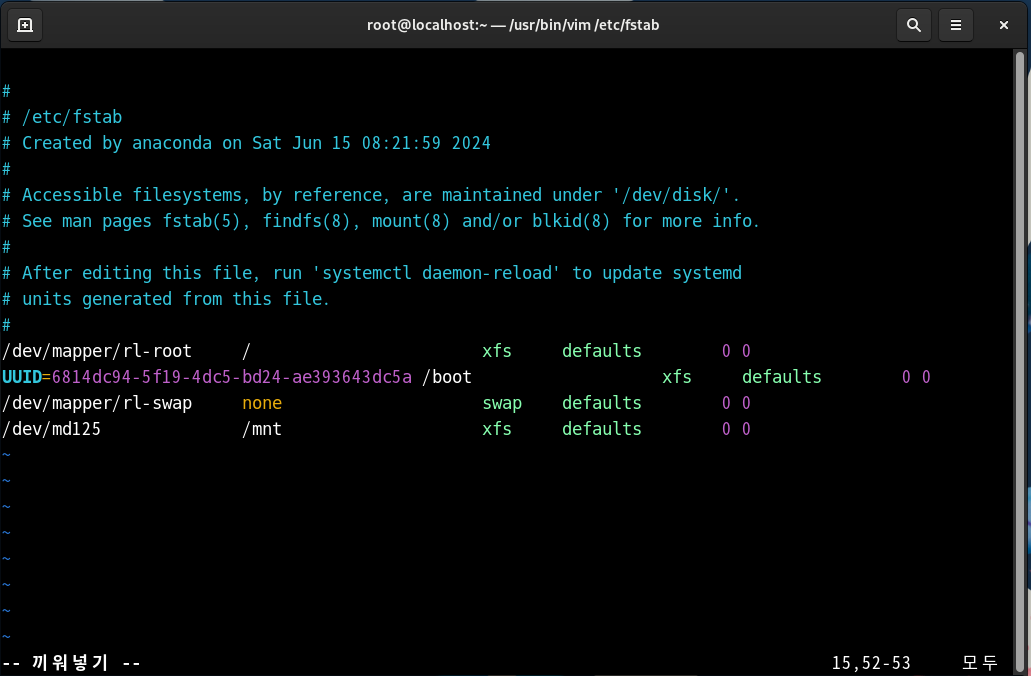

vi /etc/fstab을 이용하여 fstab에서 md125를

mnt 디렉터리 경로로 설정하고 저장

reboot를 실행하고 다시 확인 시 md125가 성공적으로 생성되었다

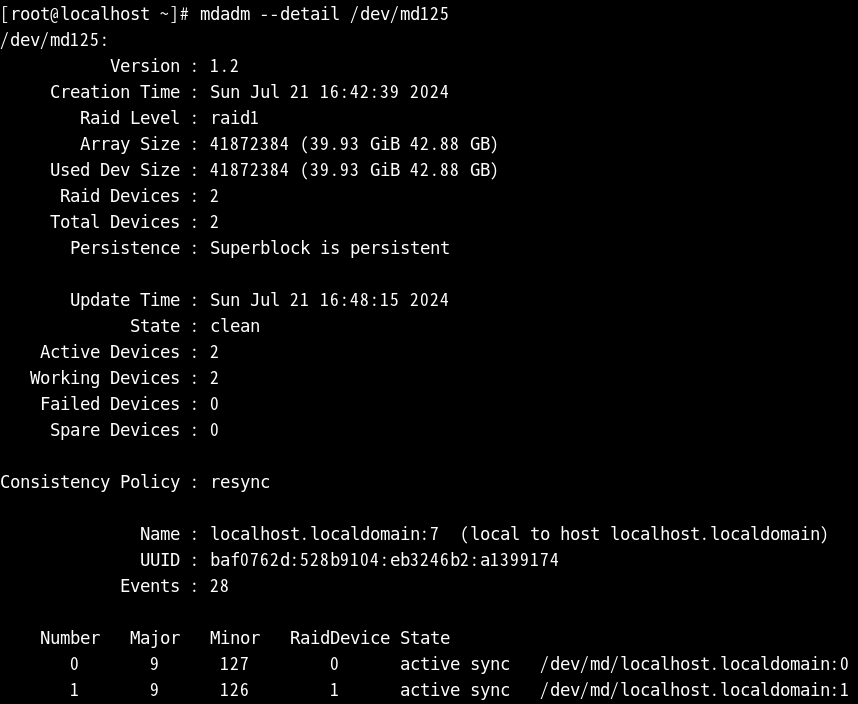

md125의 상세 정보를 확인하면 나머지127(md0)과 126(md1)이 나타난다

125의 경우 127과 126을 묶어서 생성한 것이기 때문에 화면처럼 확인된다

미러링으로 묶었기 때문에 125를 삭제하게 되어도 하나는 남게 된다

127을 하나로 묶고, 126을 하나로 묶어 다시 묶게 되면 125가 되는 과정을 진행했다

화면을 확인하게 되면 126과 127은 raid0이며, 125의 경우 raid1로 확인할 수 있다

RAID의 경우 같은 용량을 사용, 낮은 용량을 사용하게 되면

적은 쪽으로 맞춰지며 나머지는 버려지게 된다

용량을 다 채워 사용하고 싶다면 lenear로 하면 되고,

낮은 용량과 높은 용량을 합칠 수 있다

ex) level=lenear의 경우 10G+20G=30G가 되고,

나머지 레벨의 경우 용량이 적은 쪽으로 맞춰지는 점 참고

=========================================

[사용자 관리]

01. 사용자 종류

> root 사용(관리자)

#

> 일반 사용자

$

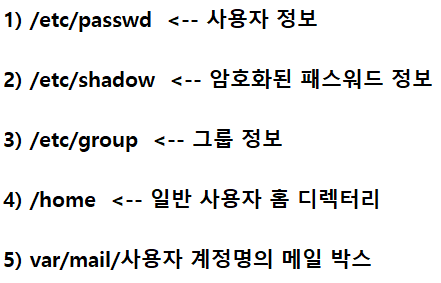

02. 사용자 관련 파일/디렉터리

03. 사용자 계정 생성/수정/삭제

1) 사용자 계정 생성

#useradd [계정명]

#useradd test

> 패스워드 변경

#passwd [계정명]

> 123456

> 123456

2) 사용자 계정 삭제

#userdel [옵션] [계정명]

#userdel -r test

<실습>

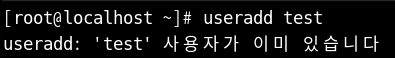

이미 있는 사용자의 경우 생성이 불가하다는 메시지가 뜬다

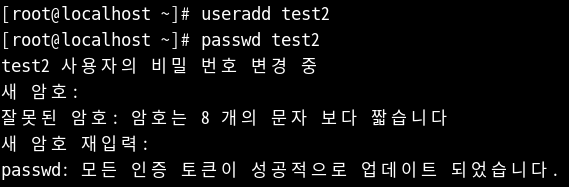

없는 test2를 생성하고 비밀번호를 설정한 후

해당 xwindows 상태에서 생성한 test2의 로그인을 시도해 본다

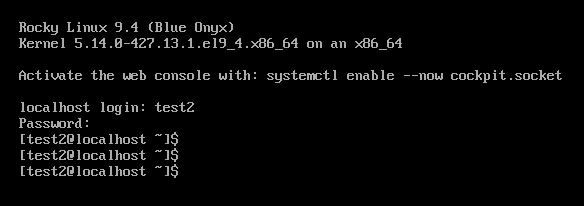

정상적으로 로그인이 되었다면 화면처럼 나타나게 된다

*ctrl+art+f3를 띄우면 해당 화면으로 xwindows 모드 사용 가능

ctrl+art+f4 -> 새 창 띄우기

ctrl+art+f2 -> xwindows 모드에서 나오는 방법

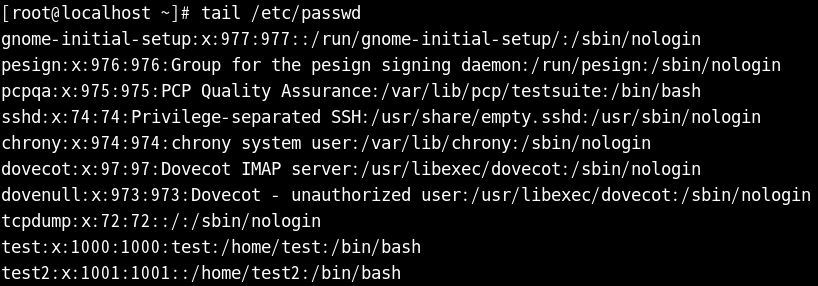

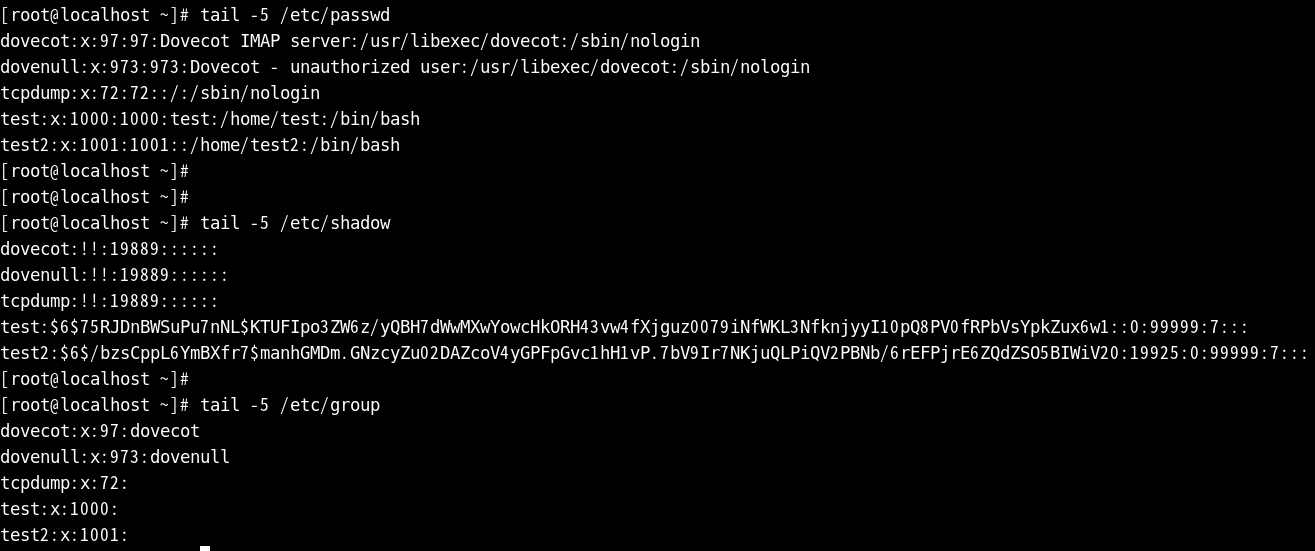

passwd에도 test2가 생성된 걸 확인할 수 있고

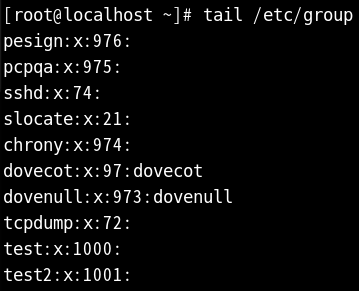

passwd와 마찬가지로 shadow와 group에서도 확인할 수 있다

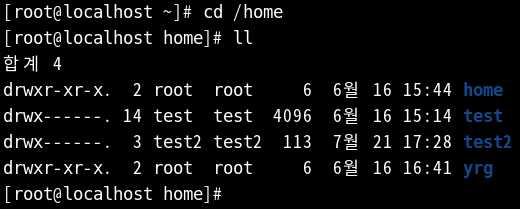

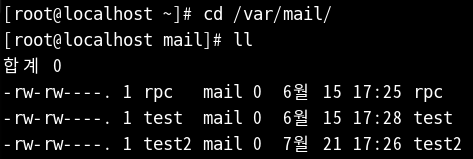

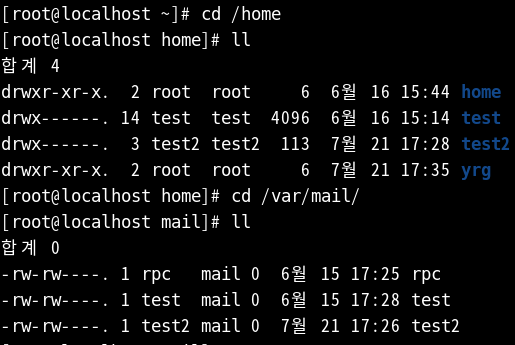

home과 mail 디렉터리에서도 사용자 확인이 가능하다

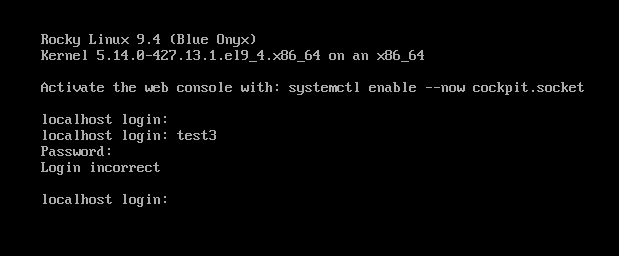

이번에는 사용자 생성 후 패스워드를 변경하지 않고 진행해 본다

패스워드를 변경하지 않으면 생성한 사용자로 진입이 불가하다

그렇기 때문에 사용자 생성 시 반드시 패스워드 변경까지 마쳐야 된다

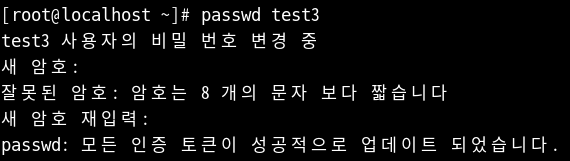

passwd 계정명을 지정해 주지 않을 시 root 패스워드가 변경된다

그렇기 때문에 반드시 passwd 뒤에는 사용자명을 입력하여 변경시켜 준다

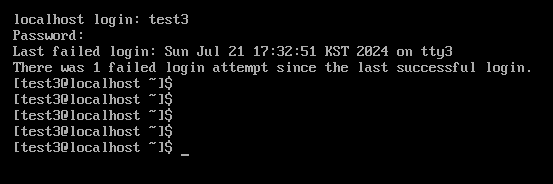

패스워드 변경 후 정상적으로 로그인이 되는 화면

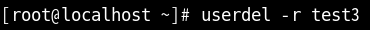

이번에는 삭제를 진행해 보려고 한다

-r 옵션을 이용하여 test3 사용자를 삭제시키게 되면

passwd와 home 디렉터리에서 모두 삭제가 된다

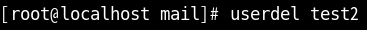

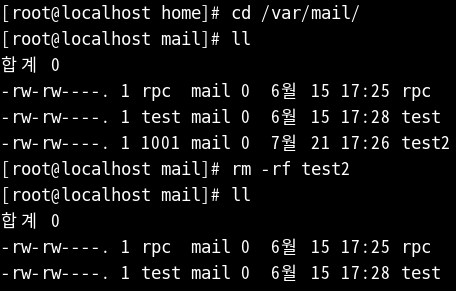

반면에 옵션을 주지 않고 test2를 삭제시키게 되면

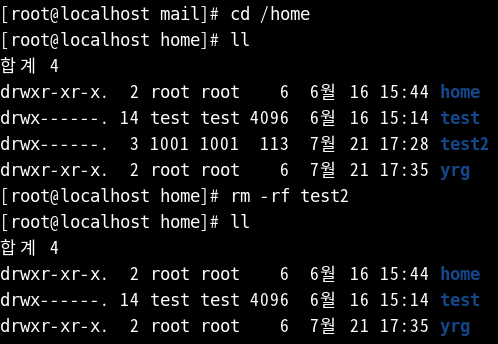

passwd에서는 지워지나 나머지 디렉터리에서는 사용자가 존재하는 상태가 된다

확인을 위해 디렉터리로 이용하여 확인하게 되면 그대로 test2가 남아 있다

이렇게 되면 rm -rf로 test2를 삭제가 가능하다

강의 소감

오늘 강의 중 RAID 부분에서 헷갈리는 부분이 많았다

그래서 강의 듣는 날 중에 오늘 제일 많은 질문을 한 것 같다

그래도 그 질문들을 통해 완전히 이해하게 됐고 직접 미션을 성공시킬 수도 있었다

모를 때는 물어보고 실행하는 것이 이 강의 실습들의 가장 좋은 방법 같다

'리눅스 마스터' 카테고리의 다른 글

| 리눅스 마스터 12 (0) | 2024.07.29 |

|---|---|

| 리눅스 마스터 11 (1) | 2024.07.27 |

| 리눅스 마스터 9 (0) | 2024.07.21 |

| 리눅스 마스터 8 (0) | 2024.07.14 |

| 리눅스 마스터 7 (0) | 2024.07.13 |